해당 강연에서 윤희택 교수는 “자율 제조를 위한 디지털 트윈 기술 현황 및 전망” 의 주제로 전문가 강연을 진행합니다.

해당 링크: (사)대한기계학회

Dr. Yun has achieved 1,000 citations in Google Scholar.

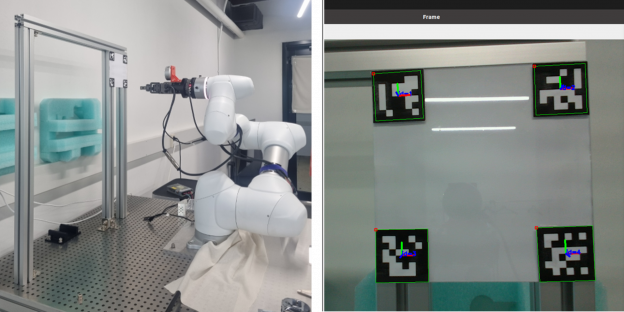

Sieun Lee (KAIST ME) has developed a program for a collaborative robot to align with a object using ArUco Marker. Knowing the position of the markers with a camera attached to the robot will be utilized to autonomous robots in machine tools: knowing the machine’s door and move a workpiece without any collisions. She implemented the application after she learned robot control using ROS (Robot Operating System) and image processing in OpenCV during the summer’s individual research, 2024.

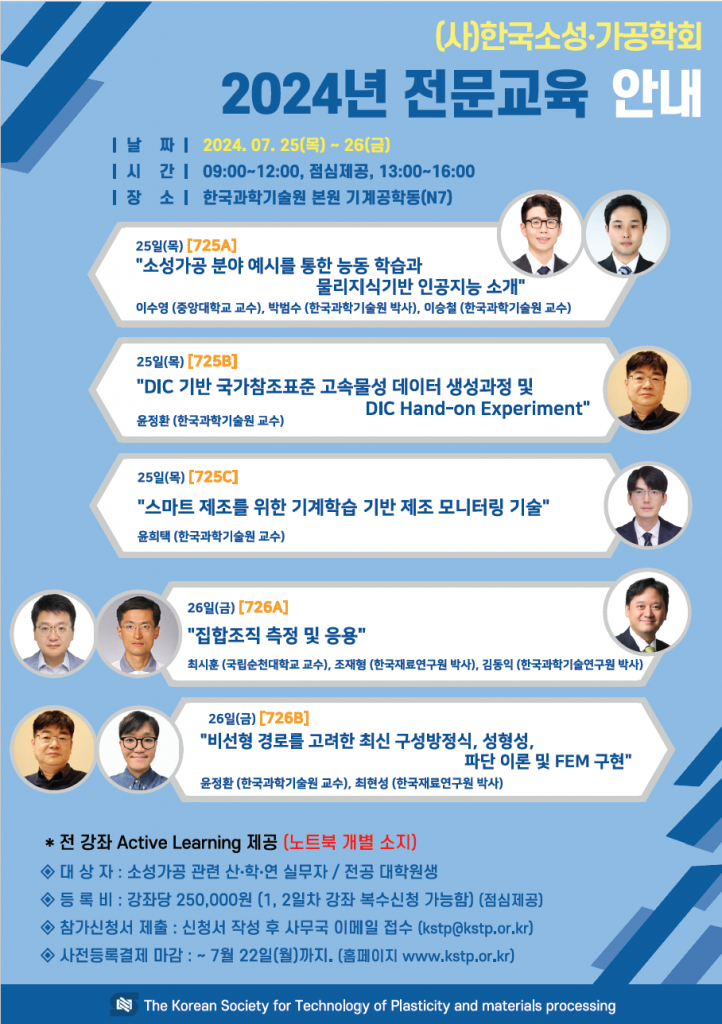

해당 전문 교육에서 윤희택 교수는 “스마트 제조를 위한 기계학습 기반 제조 모니터링 기술” 을 강의했습니다.

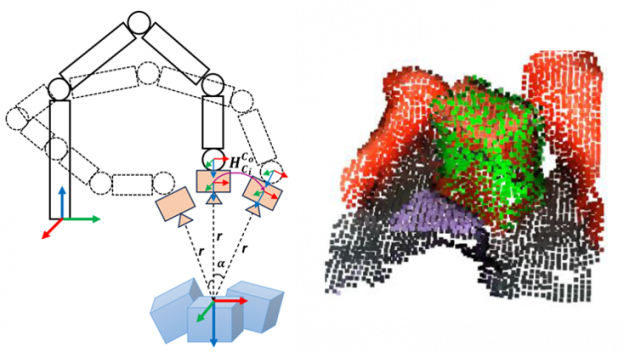

In his individual study and undergraduate thesis in 2023, Ahn Ho Tung (KAIST ME) conducted research to utilize multiple 3D shots to find objects for autonomous robotic bin picking. 3D depth sensors has measurements errors due to their optical limitation. He developed a method how the multiple shots for different angles by an affordable depth sensors with robot can minimize the position error of an object . Based on the method, the robot could improve success rate to pick up objects in random positions. In this study, ROS melodic is used to control the robot. YOLO AI model by Pytorch was used to find top object from a cluttered bin.

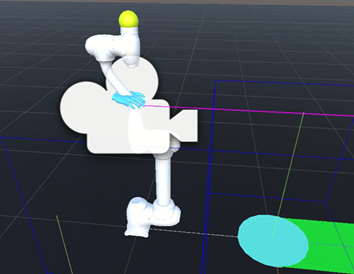

In his individual study, Minseo Jang (장민서, KAIST ME) has developed virtual reality-based interface for a collaborative robot (Doosan Robotics). It is the digital twin that can be manipulated freely in the virtual space, which is aimed to a new interface for virtual manufacturing and human-AI collaborative space. Unity (game engine) with ROS melodic are used.

본 연구는 자체 개발한 청진기 기반 내부 음향 센서 (Internal Sound Sensor) 의 성능을 증명하고, 오토인코더(Autoencoder) 신경망 모델 (Neural Network, NN) 을 활용하여 공정 이상을 예측하는 플랫폼을 제안하였다. 로봇 내부의 소리와 오토인코더를 통해 산업용 로봇의 허용 중량 초과 여부를 판단함을 시연했다.

공정 이상시의 데이터는 정상 상태 대비 수집량이 제한적이며, 이는 기계학습 모델에 데이터 불균형을 초래하는데, 이는 오토인코더로 문제점을 해결할 수 있다. 오토인코더는 입력 데이터를 똑같이 복제해낼수 있는 신경망 모델로, 정상 데이터로만 학습할 수 있으며, 충분히 학습된 경우 이상 투입 데이터를 정상 투입 데이터만큼 복제해내지 못하는 특성이 있다. 따라서 투입 데이터와 복제 데이터의 차이를 계산하여 이상 여부를 파악할 수 있으며, 생산 공정에서 이상 데이터 수집의 어려움 또한 극복할 수 있다. 오토 인코더는 반도체 장비의 이상에 적용한 연구 외에는 다른 분야의 적용 사례가 보고되지 않았으며, 특히 산업용 로봇의 이상 판단에는 제시되지 않았다.

또한 제조 공정과 장비를 모니터링하기 위한 음향 및 진동 센서로 마이크와 가속도계 등이 사용되어 왔다. 하지만 해당 센서들은 외부 소음에 취약하거나, 신호 처리를 위한 별도의 장비가 필요하다. 이에 본 연구에서는 청진기를 기반으로 한 내부 음향 센서를 대안으로 제시하였다. 청진기 센서는 청진기와 마이크가 결합된 것으로, 외부의 소음을 최대한 억제하면서 내부의 진동을 측정할 수 있다. 또한 임베디드 PC 를 통해 녹음이 가능하므로, 별도의 앰프나 컨디셔닝 장비가 필요없는 등 저전력, 저비용의 특성을 갖추고 있으므로, 사물 인터넷에서 활용이 가능하다.

본 연구는 물체들을 잡아내는 로봇 (Robotic Bin Picking) 을 위해 사람이 협동로봇을 통해 시연하고, 이때 측정된 2D/3D 이미지를 활용해 무작위로 분산된 물체 중 잡을수 있는 것을 찾아내기 위한 신경망 모델을 자동으로 학습할 수 있는 플랫폼을 개발했다. 해당 신경망 모델은 YOLOv5 (You Only Look Once) 로, 2D 이미지에서 대상 객체와 그 영역을 빠르게 찾아낼 수 있다. 이 결과로 제한된 영역에서 캡쳐된 3D 이미지를 통해 물체들 위에 2D 이미지를 투영 및 합성하여 신경망 모델을 학습했다. 또한 사람이 직접 협동 로봇 팔을 잡고 움직일 수 있는 직접 티칭 (Direct Teaching) 기능을 통해 로봇이 물체에 접근하고 잡아야 할 경로를 학습하였으며, 해당 물체의 3D 이미지 레퍼런스를 수집할 수 있으며, 수직 방향으로 캡쳐해 음영을 줄일 수 있다. 이후 두 3D 이미지를 비교해 로봇의 위치와 자세를 계산할 수 있다. 이러한 일련의 과정은 사람과 로봇이 협업하여 인공지능 모델을 학습시킨 것이며, 신경망 모델 학습을 위한 데이터 라벨링과 전처리 과정등을 획기적으로 줄일 수 있다.

본 연구는 로봇이 통에 담긴 물체를 잡아내는 어플리케이션에서 ,기존 연구와 다른 방식으로 접근하여 사람의 유연성과 판단 능력을 활용하여 문제점을 해결하고자 하였다. 특히 사람과AI가 협업을 통해학습 데이터의 양과 처리능력을 줄일수 있는 로봇 소재투입 장치 플랫폼을 제안하였다. 해당 플랫폼으로 소재가 통(Bin) 에 담겨저 랜덤하게 위치해 있더라도 로봇이 자동으로 소재를 잡을 수 있으며, 적은 학습량으로 높은 성공률을 보여주었다.

본 플랫폼은 사람이 인터페이스를 통해 물체 잡기를 시연하는 부분과, 시연을 통해 구성된Convolutional Neural Network (CNN) 신경망 모델을 통해 로봇이 자가 학습하는 부분으로 이루어져 있다. 사람 인터페이스는 GUI 프로그램이며, Bin 의 Depth image 위에 잡을수 있다고 생각되는 물체를 클릭하여, 로봇이 잡기를 시연하고 난 후 성공 여부 및 해당 이미지 결과를 기록한다. 다음, 이 소규모의 작업자 시연으로 수집된 데이터를 통해 초기 CNN 모델을 생성한다. CNN 모델의 입력은 Depth image 이며, 출력은 잡기 성공 여부(%) 이다. 이후 해당 초기 모델을 통해 Depth image를 스캔하여 로봇이 자동으로 잡기를 시도한 후, 잡기의 성공/실패 여부를 자가 학습하여 CNN 모델의 정확성을 높인다.

총100회의 시연을 통해CNN 모델을 학습하고 나서, 로봇이CNN 모델을 통해 잡을수 있는 물체를 예측하고 잡기를 스스로 시도하였다.

다음, 총2000회의 자가 학습을 통해 CNN 모델의 잡기 성공률을 초기74% 에서87% 까지 증가시킬 수 있었다.

사람의 초기 학습과 로봇 자가 학습을 통해 빠르게 CNN 모델을 만들수 있었다. 해당 성공률은 최근 연구들과 동등한 수준이며, 학습 데이터의 양도 기존 연구 대비 최소화 할 수 있었다.

산업용 로봇이나 공작기계는 복잡한 인터페이스 때문에 바로 운용하기 어렵고, 별도의 교육과 오랜 기간 경험을 통해 익숙해지게 됩니다. 최근 숙련자의 은퇴와 인구 감소 등으로 인해 제조업의 인력 공급이 문제가 되고 있으며, 이를 극복할 수 있는 방법의 하나로 가상현실 (Virtual Reality, VR) 을 통해 보다 직관적인 인터페이스를 생각해 보았습니다. 또한 스마트 제조에서 빅데이터와 인공지능 등의 사이버 시스템과 협업할 수 있는 방법으로, 가상 공간에서 사람이 가상의 물리 시스템과 사이버 시스템 안에서 일하는 아이디어를 생각했습니다. 이러한 개념을 가진 인터페이스를 게임엔진, 가상현실, ROS, MTConnect 와 같은 미들웨어로 구현했고, 산업용 로봇으로 물체를 잡아 이송하는 공정을 데모로 시연했습니다.